Χαλλιορή Μαρκέλλα

Το άρθρο αυτό αποτελεί μία εισαγωγή στη συζήτηση των έμφυλων προκαταλήψεων που εντοπίζονται στα συστήματα Τεχνητής Νοημοσύνης. Εξετάζοντας ορισμένες προβληματικές περιπτώσεις, και χρησιμοποιώντας τον φακό των φεμινιστικών θεωριών, θα προσπαθήσουμε να αναδείξουμε την πολυπλοκότητα και την ανάγκη για άμεση απεύθυνση του ζητήματος. Είναι οι έμφυλες αλγοριθμικές προκαταλήψεις απλώς μια τεχνική ατέλεια;

Η ΠΡΟΒΛΕΨΗ ΤΟΥ DREYFUS ΚΑΙ Η ΤΕΧΝΗΤΗ ΝΟΗΜΟΣΥΝΗ ΣΗΜΕΡΑ

Το 1992 στο βιβλίο του What computers still can’t do, ο Dreyfus ανακοινώνει τον «θάνατο της τεχνητής νοημοσύνης», που κατά την άποψή του δεν έζησε ποτέ (Dreyfus, 1992). Πρόκειται για το τρίτο κατά σειρά έργο που ο συγγραφέας αφιερώνει στην κριτική της νεοεισηγμένης τότε τεχνολογίας της Τεχνητής Νοημοσύνης, καταδικάζοντας την αφελή αισιοδοξία των ερευνητών, ότι οι μηχανές θα μπορέσουν κάποτε να αναπαραστήσουν –έως και να αντικαταστήσουν– την ανθρώπινη νοημοσύνη. Η δυσπιστία του εντοπιζόταν στην ίδια τη συγκρότηση των συστημάτων: τα συστήματα τεχνητής νοημοσύνης, όπως και η επιστήμη των υπολογιστών εν γένει, βασίζονται στη μοντελοποίηση πληροφοριών με τη χρήση μαθηματικού φορμαλισμού και κανόνων συμβολικής λογικής. Αντίθετα, η ανθρώπινη νοημοσύνη, η ικανότητα για μάθηση, κατανόηση και κρίση προκύπτει ως ένα κράμα συνειδητών και ασυνείδητων λειτουργιών, οι οποίες, σε συνδυασμό με την βιωματική αλληλεπίδραση με το περιβάλλον του νοούντος, είναι αδύνατο να τυποποιηθούν με μαθηματικούς όρους. Αντλώντας από τη φιλοσοφική παράδοση της φαινομενολογίας, τη σημασία της ενσώματης εμπειρίας στη νόηση και την αδυναμία τυποποίησης της ανθρώπινης συμπεριφοράς, το πόρισμα του Dreyfus ήταν κατηγορηματικό: οι υπολογιστές δεν θα μπορέσουν ποτέ να μιμηθούν πλήρως την ανθρώπινη σκέψη.

Παρόλα αυτά, περίπου τριάντα χρόνια αργότερα, είναι δύσκολο να αποφανθεί κάποιος σε ποιο βαθμό έχει επιβεβαιωθεί η πρόβλεψη του Dreyfus. Τα συστήματα τεχνητής νοημοσύνης (εφεξής ΤΝ) αποτελούν αναπόσπαστα κομμάτια των σύγχρονων κοινωνιών, επηρεάζοντας την καθημερινή μας ζωή με πρωτόγνωρους τρόπους. Δεν πρόκειται απλά για μηχανές που εκτελούν εργασίες· πρόκειται για συστήματα που λαμβάνουν κρίσιμες αποφάσεις, –συχνά απουσία ανθρώπινης παρέμβασης– και έχουν μετασχηματίσει ριζικά την έννοια της αυτοματοποίησης και τον βαθμό στον οποίο βασιζόμαστε σε αυτήν. Ταυτόχρονα, η ραγδαία εξέλιξη της επιστήμης και της τεχνολογίας έχει καθορίσει τον τρόπο που συλλέγουμε πληροφορίες, αντιλαμβανόμαστε και αλληλεπιδρούμε με τον κόσμο. Για πρώτη φορά, τα δεδομένα που αφορούν τον ατομικό και κοινωνικό βίο είναι, λόγω της ψηφιακής μορφής τους, σε τέτοιο βαθμό συγκεντρωμένα, προσβάσιμα και επεξεργάσιμα όσο σε καμία άλλη στιγμή της ιστορίας (Τάσης, 2019).

Χωρίς αμφιβολία, το άλλοτε αποκύημα της επιστημονικής φαντασίας, η TN, αποτελεί πλέον τη βάση του τεχνοεπιστημονικού –και μη– κόσμου και την πιο καθοριστική τεχνολογία του 21ου αιώνα. Χάρη στην υπερπληθώρα διαθέσιμων δεδομένων, στην υπολογιστική ισχύ αυτών των συστημάτων και στο επαγόμενο θριαμβευτικό πλεονέκτημα που κατέχουν στην ταχεία και ακριβή επίλυση προβλημάτων, οι υπολογιστές «συναγωνίζονται» σήμερα τους ανθρώπους στην ανάληψη και εκτέλεση σύνθετων εργασιών, συχνά μάλιστα υπερτερώντας (Μήτρου, 2023). Επιστημικές αρετές, όπως η ταχύτητα, η ακρίβεια, η απλούστευση πολύπλοκων εργασιών, η επεξεργασία τεράστιου όγκου δεδομένων και η αμεροληψία, αποτελούν ταυτόχρονα τη βάση των προσδοκιών μας από τα συστήματα, γεγονός στο οποίο θεμελιώνεται (;) η ανάθεση σε αυτά έως τώρα «ανθρώπινων» καθηκόντων. Ανεξαρτήτως της πρόβλεψης του Dreyfus για αποτυχία προσομοίωσης της ανθρώπινης νόησης, τα συστήματα ΤΝ έχουν υπεισέλθει σε κάθε πτυχή της ιδιωτικής και δημόσιας σφαίρας, συνοδευόμενα από σημαντικές ευκαιρίες: από την εξατοµίκευση των διαφηµίσεων που ϕτάνουν σε εµάς µέχρι την ενηµέρωση νοµικών αποφάσεων, την ιατρική, την εκπαίδευση και την πρόσληψη προσωπικού, η σηµασία των Συστηµάτων ΤΝ στις σύγχρονες κοινωνίες είναι καινοφανής και αυξανόµενη.

Ωστόσο τα τελευταία χρόνια, οι αρχικές αντενδείξεις ότι τέτοια συστήματα θα λειτουργούσαν ως αγωγοί ανθρώπινης ευημερίας και υπέρβασης των κοινωνικών αντιθέσεων έχουν δώσει τη θέση τους σε μία σκληρή βεβαιότητα: η χρήση τέτοιων συστημάτων για τη λήψη αποφάσεων ισοδυναμεί συχνά με όξυνση της κοινωνικής πόλωσης, την καταπάτηση θεμελιωδών δικαιωμάτων και ελευθεριών. Τα συστήµατα ΤΝ αποδεικνύονται, ως κοινωνικά προϊόντα, βαθιά ενσωµατωµένα στα κοινωνικά, πολιτικά και πολιτισµικά πλαίσια µέσα στα οποία παράγονται. Ο όγκος τεκµηρίων που υποδεικνύουν ότι τα συστήµατα ΤΝ συχνά αντανακλούν και διαιωνίζουν τις υφιστάµενες κοινωνικές προκαταλήψεις σε βάρος των διαφορετικών µειονοτήτων συνεχώς αυξάνεται: συστήµατα αναγνώρισης προσώπου αποτυγχάνουν να αναγνωρίσουν άτοµα µε σκούρο δέρµα, αλγόριθµοι προσλήψεων απορρίπτουν αυτόµατα βιογραφικά που περιέχουν λέξεις όπως «γυναικείο», δικαστικά συστήµατα προγνωστικής αξιολόγησης στοχοποιούν δυσανάλογα ορισμένες µειονότητες χαϱακτηρίζοντάς τες «πιο επικίνδυνες».

Φαίνεται λοιπόν πως οι κυρίαρχες κοινωνικές πεποιθήσεις και προκαταλήψεις εµφωλεύουν στις αλγοριθµικές δοµές, µε αποτέλεσµα οι εφαρµογές της ΤΝ συχνά να συνεπάγονται τη διαιώνιση των ίδιων διακρίσεων που καλούνται να επιλύσουν. Ανάµεσα στις διεγνωσµένες διακρίσεις, η έµφυλη µεροληψία των συστηµάτων ΤΝ, αποτελεί το κέντρο βάρους του σώματος της βιβλιογραφίας και των ερευνών που σχετίζονται με την αλγοριθμική δικαιοσύνη. Πώς λοιπόν βλέπει, μιλά και αποφασίζει η ΤΝ για τις γυναίκες;

ΠΡΟΣΔΟΚΙΕΣ ΠΟΥ ΔΕΝ ΠΡΑΓΜΑΤΩΘΗΚΑΝ: ΟΙ ΠΡΟΒΛΗΜΑΤΙΚΕΣ ΠΕΡΙΠΤΩΣΕΙΣ

1) Αλγόριθμοι Αναγνώρισης και Δημιουργίας Εικόνας

Η εικόνα των γυναικών αποτέλεσε για χρόνια (αν δεν συνεχίζει να είναι) πηγή πολλών στερεοτυπικών αντιλήψεων εις βάρος τους, καθώς και των καταπιεστικών πρακτικών που τις συνοδεύουν. Δεν αποτελεί λοιπόν έκπληξη το γεγονός ότι οι αλγόριθμοι αναγνώρισης εικόνας μετουσιώνουν το ψηφιακό ανάλογο των προκαταλήψεων που υπάρχουν στον «πραγματικό» κόσμο. Όπως φαίνεται, η «φαινομενολογία» των αλγορίθμων αναγνώρισης εικόνας δεν κατάφερε να αποδράσει από τις νόρμες του κοινωνικού «αποφαίνεσθαι».

Σε έρευνα που δημοσιεύτηκε το 2021, οι Steed και Caliskan αποπειράθηκαν να ποσοτικοποιήσουν τις έμφυλες προκαταλήψεις που παρεισφρέουν στα οπτικά δεδομένα εκπαίδευσης των αλγορίθμων και συνεπώς στα αποτελέσματά τους. Η ιδέα του πειράματός τους ήταν απλή: περικόπτοντας φωτογραφίες και κρατώντας μόνο τα πρόσωπα των ανδρών και γυναικών που απεικονίζονταν, ζήτησαν από τον αλγόριθμο να συμπληρώσει την εικόνα. Όταν το πείραμα ολοκληρώθηκε διαπίστωσαν πως το 52,5% των φωτογραφιών των γυναικών τις απεικόνιζαν με μπικίνι ή χαμηλό ντεκολτέ. Αντιθέτως, το 42,5% των ανδρών, όπως τους φαντάστηκε ο αλγόριθμος, φορούσαν κουστούμι (Steed et al., 2021).

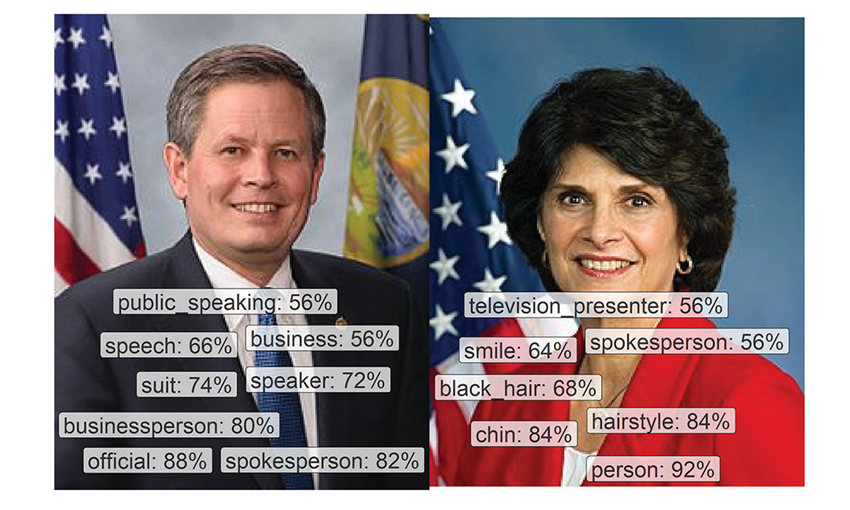

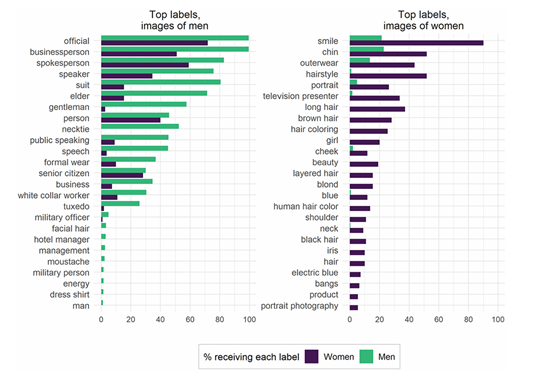

Σε αντίστοιχη μελέτη που πραγματοποιήθηκε το 2020, ο αλγόριθμος αναγνώρισης εικόνας της Google (Google Cloud Vision) τροφοδοτήθηκε με επιλεγμένες φωτογραφίες ανδρών και γυναικών μελών του Κογκρέσου. Παρά την ομοιογένεια των δεδομένων εισόδου για τις δύο διαφορετικές δημογραφικές ομάδες, οι έξοδοι του μοντέλου φανέρωσαν μία αυθαίρετη ασυνέπεια στην αναγνώριση των χαρακτηριστικών των εικονιζόμενων: η αντίστοιχη απόδοση «ετικετών» (labels), αναπαρήγαγε τις στερεοτυπικές αντιλήψεις που σχετίζονται με τον έμφυλο καταμερισμό της εξουσίας (βλ. Εικ. 1 & 2). Συγκεκριμένα, και παρά το κοινό για όλους «φόντο» και την ενδυματολογική ομοιομορφία, οι ετικέτες που αντιστοιχήθηκαν στους άνδρες ήταν, μεταξύ άλλων, «δημόσιος ομιλητής» και «λόγος» ενώ στις γυναίκες αναγνωρίστηκαν χαρακτηριστικά όπως «τηλεπαρουσιάστρια» και «χαμόγελο» (Schwemmer et al., 2020).

Εικόνα 1: Η υπηρεσία αναγνώρισης εικόνας της Google τείνει να «βλέπει» διαφορετικά άνδρες και γυναίκες. Πηγή: Schwemmer et al., 2020.

Εικόνα 2: Η συχνότητα απόδοσης ετικετών σε φωτογραφίες ανδρών και γυναικών. Πηγή: Schwemmer et al., 2020.

2) Αλγόριθμοι Αυτόματης Μετάφρασης

Ένας άλλος τρόπος με τον οποίο εντείνεται το ψηφιακό κοινωνικό χάσμα (εξαιτίας μεροληπτικών αναπαραστάσεων), είναι μέσω των συστημάτων Επεξεργασίας Φυσικής Γλώσσας. Η Επεξεργασία Φυσικής Γλώσσας (Natural Language Processing ή NLP) είναι ένας υποτομέας της ΤΝ και της γλωσσολογίας που ασχολείται με την ανάπτυξη συστημάτων υπολογιστών με στόχο την ανάλυση και την επεξεργασία γλώσσας. Μεταξύ άλλων, σε αυτή την τεχνοτροπία βασίζονται τα μοντέλα αυτόματης μετάφρασης. Δεδομένου ότι αυτοί οι αλγόριθμοι εκπαιδεύονται σε τεράστιο όγκο κειμένων για να αναγνωρίσουν γλωσσικά μοτίβα, είναι αναμενόμενο πως «απορροφούν» στη μάθησή τους όλες τις προκαταλήψεις που είναι εγγεγραμμένες σε αυτά (Nicholas et al., 2023).

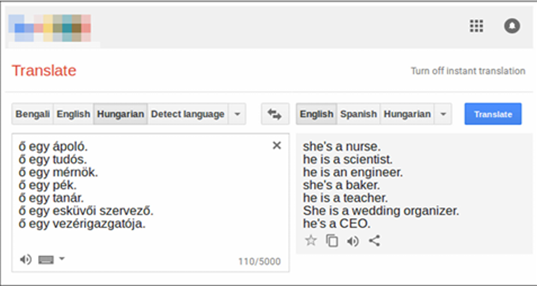

Στη μελέτη τους που δημοσιεύτηκε το 2019, οι Prates, Avelar και Lamb, εξέτασαν την μετάφραση προτάσεων από 12 ουδέτερες ως προς το φύλο γλώσσες, όπως τα Ουγγρικά και τα Κινέζικα, στα Αγγλικά, χρησιμοποιώντας το Google Translate. Συγκεκριμένα, οι προτάσεις που χρησιμοποιήθηκαν αφορούσαν διάφορες θέσεις εργασίας (βλ. Εικ. 3). Αυτό που έδειξε η έρευνα είναι η συστηματική «ανάθεση» ανδρικών αντωνυμιών σε επαγγέλματα των Θετικών Επιστημών, ακόμα και αν αυτό ερχόταν σε διαφωνία με την ποσοστιαία στελέχωση των επαγγελμάτων στον πραγματικό κόσμο (Prates et al., 2019). Τέτοιου είδους προκαταλήψεις παρέχουν ένα «παράθυρο» στον τρόπο που η κοινωνία μας μιλάει (και γράφει) για τις γυναίκες στον χώρο εργασίας. Πώς ακριβώς όμως εγγράφεται στα δεδομένα η συστημική ασυμμετρία;

Οι ενσωματώσεις λέξεων (word embeddings) είναι ένας τρόπος αναπαράστασης των λέξεων ως αριθμητικών τιμών (διανυσμάτων), ώστε να έρθουν σε μορφή «κατανοητή» από ένα υπολογιστή. Στην ουσία πρόκειται για ένα «χάρτη» λέξεων, όπου λέξεις με νοηματική συνάφεια εντοπίζονται κοντά η μία στην άλλη και το αντίστροφο. Ενδεικτικά, σε ένα πρόβλημα της μορφής «Παρίσι: Γαλλία => Τόκιο: x», ο αλγόριθμος επιστρέφει σαν έξοδο τη λέξη «Ιαπωνία». Ωστόσο, στην περίπτωση του «άνδρας: γυναίκα => προγραμματιστής: x», ο αλγόριθμος επιστρέφει «νοικοκυρά» (Bolukbasi et al., 2016). Το 2017, ερευνητές του πανεπιστημίου Stanford έκαναν μία απόπειρα να ποσοτικοποιήσουν το «σφάλμα» της αναπαράστασης του έμφυλου εργασιακού καταμερισμού. Ερεύνησαν το κατά πόσο οι συσχετίσεις μεταξύ γυναικών και επαγγελμάτων στις ενσωματώσεις λέξεων είναι αντιπροσωπευτικές της πραγματικότητας. Αυτό που διαπίστωσαν είναι η πριμοδότηση του ανδρικού φύλου: ακόμα και τα επαγγέλματα στα οποία απασχολούνται ίσος αριθμός ανδρών και γυναικών εντοπίζονται πιο κοντά σε λέξεις που συνδέονται με τους άνδρες (Garg et al., 2018).

Εικόνα 3: Παράδειγμα του πώς μεταφράζονται προτάσεις που αναφέρονται σε επαγγέλματα από τα –ουδέτερα ως προς το φύλο–- Ουγγρικά στα Αγγλικά. Πηγή: Prates et al., 2019.

3) Αλγόριθμοι Προσλήψεων: Η περίπτωση της Amazon

Τα παραδείγματα που προηγήθηκαν είναι ενδεικτικά του πώς μεροληπτικά συστήματα ΤΝ βλέπουν, ή μιλούν για, τις γυναίκες. Ωστόσο σε αυτά τα στιγμιότυπα, η άνιση —και άδικη— εκπροσώπηση των γυναικών φαίνεται να έχει απλά μία περιγραφική διάσταση, χωρίς άμεσες επιπτώσεις στη ζωή τους. Η δημιουργία και η χρήση του αλγορίθμου προσλήψεων της Amazon αποτελεί ένα παράδειγμα του τρόπου με τον οποίο τέτοια συστήματα λαμβάνουν αποφάσεις για τις γυναίκες. Η περίπτωση της Amazon είναι ενδεικτική του πώς οι μακροχρόνιες πρακτικές αποκλεισμού των γυναικών από συγκεκριμένες θέσεις εργασίας επανεφευρίσκονται και επανεγγράφονται στην κοινωνική πραγματικότητα την εποχή της ψηφιακότητας.

Το 2014 η Amazon υιοθέτησε ένα εργαλείο για την αξιολόγηση των βιογραφικών των υποψηφίων για τις ανοιχτές θέσεις εργασίας. Βασισμένο σε αλγορίθμους επεξεργασίας φυσικής γλώσσας και μηχανικής μάθησης, η χρήση του εργαλείου θα πληρούσε τρείς επιθυμητές προδιαγραφές: ταχύτητα, χαμηλό κόστος και ουδετερότητα. Το μοντέλο εκπαιδεύτηκε στα δεδομένα του εργατικού δυναμικού της εταιρίας και συγκεκριμένα στους υπαλλήλους των τελευταίων δέκα ετών. Στόχος ήταν να μάθει τα χαρακτηριστικά των επιτυχημένων —ως εργαζομένων— υποψηφίων, να αναζητήσει παρόμοια στοιχεία στα βιογραφικά που υποβάλλονταν για αξιολόγηση και στη συνέχεια να τα βαθμολογήσει στην κλίμακα του 5. Μέχρι το 2015 είχε γίνει αντιληπτό από την Amazon ότι παρά την ελαχιστοποίηση χρόνου και κόστους, ο αλγόριθμος αποτύγχανε σε μία από τις βασικές του επιδιώξεις: την ουδετερότητα.

Δεδομένου ότι η συντριπτική πλειονότητα του υπάρχοντος εργατικού δυναμικού σε τεχνικές θέσεις ήταν άνδρες, ο αλγόριθμος, εξαιτίας της εκπαίδευσής του σε ιστορικά δεδομένα, ήταν συστηματικά προκατειλημμένος εναντίον των γυναικών υποψηφίων. Με άλλα λόγια, το μοντέλο «συνέδεε» τις γυναίκες με την έλλειψη επιτυχίας. Έτσι, κάθε φορά που ο αλγόριθμος συναντούσε σε ένα βιογραφικό λέξεις όπως «γυναίκα» ή «κολέγιο θηλέων», το υποβάθμιζε βαθμολογικά, ενισχύοντας την πιθανότητα απόρριψης των υποψηφίων (Langenkamp et al., 2020). Η χρήση του αλγόριθμου δεν διαιώνιζε απλώς μία κοινωνική ανισότητα, αλλά την ενέτεινε: άνδρες στα ιστορικά δεδομένα -> άνδρες ως καλύτεροι υποψήφιοι εργαζόμενοι -> πρόσληψη ανδρών -> περισσότεροι άνδρες στα ιστορικά δεδομένα. Πρόκειται για βρόχο ανατροφοδότησης (feedback loop): το αρχικό μοτίβο των δεδομένων αναπαράγεται μέσω της επανάληψης της διαδικασίας, οδηγώντας σε «αυτοενίσχυση» της ανισότητας.

ΑΛΓΟΡΙΘΜΙΚΗ ΔΙΚΑΙΟΣΥΝΗ ΚΑΙ ΦΕΜΙΝΙΣΤΙΚΕΣ ΘΕΩΡΙΕΣ: ΓΙΑΤΙ ΧΡΕΙΑΖΟΜΑΣΤΕ ΚΑΛΥΤΕΡΗ ΤΕΧΝΗΤΗ ΝΟΗΜΟΣΥΝΗ;

Φαίνεται λοιπόν πως, η ανάπτυξη των εφαρμογών της ΤΝ και η ταυτόχρονη αναγνώριση των αδυναμιών της έχει οδηγήσει ψηφιακούς ουτοπιστές και τεχνοσκεπτικιστές σε κοινό έδαφος. Είναι δύσκολο ακόμα και για τους πιο αισιόδοξους να αγνοήσουν τα προβληματικά αποτελέσματα της ΤΝ και τους κινδύνους που προκύπτουν από αυτά. Τα παραδείγματα που παρουσιάστηκαν παραπάνω «στοιβάζονται» μαζί με τις υπόλοιπες ενδείξεις ότι επιστήμη και τεχνολογία δεν είναι, και ούτε πρόκειται να είναι ποτέ, αξιακά ουδέτερες. Είναι προφανές πως ιδιαίτερα η ΤΝ, μια τεχνολογία τόσο ρευστή ως προς τα όρια και τις δυνατότητες της, αναπόφευκτα παίρνει το σχήμα του κοινωνικού πλαισίου μέσα στο οποίο γεννιέται.

Η παρείσφρηση σεξιστικών αξιών στο σχεδιασμό, την υλοποίηση και την εφαρμογή της ΤΝ δεν αποτελεί πρωτοφανές συμβάν στην ιστορία της επιστήμης και της τεχνολογίας. Πρωτοφανής είναι όμως ο τρόπος με τον οποίο αποκρύπτεται και ενισχύεται η κοινωνική ανισότητα, ιδιαίτερα εις βάρος των γυναικών, από προκαταλήψεις που είναι «εγγεγραμμένες στον κώδικα των μηχανών», φαινόμενο το οποίο η Noble ορίζει ως αλγοριθμική καταπίεση (Noble, 2018). Την ίδια χρονιά, η Eubanks γράφει: «οι μηχανές που εκπαιδεύονται σε δεδομένα-προϊόντα άνισων κοινωνιών τείνουν να μεγεθύνουν τις υπάρχουσες ανισότητες, μετατρέποντας τις ανθρώπινες προκαταλήψεις σε φαινομενικά αντικειμενικά γεγονότα. Mια επιδεξιότητα υψηλής τεχνολογίας που ενθαρρύνει τους χρήστες να αντιλαμβάνονται βαθιά πολιτικές αποφάσεις ως φυσικές και αναπόφευκτες» (Eubanks, 2018).

Χωρίς αμφιβολία, είναι μεγάλος ο όγκος της βιβλιογραφίας σήμερα που πηγάζει από την αποκάλυψη της «βλάβης» της ΤΝ, άλλες φορές νοημένης ως τεχνικού σφάλματος και άλλοτε ως εγγενούς αδυναμίας. Σε κάθε περίπτωση φαίνεται πως τα θεμελιώδη φιλοσοφικά, κοινωνικά και πολιτικά ερωτήματα που τίθενται για το σύγχρονο άνθρωπο με αφορμή την ΤΝ δεν είναι νέα, αλλά επαναδιατυπώνονται στο παρασκήνιο των ισχυρών μετασχηματιστικών αλλαγών. Η εισαγωγή της ΤΝ μας προ(σ)καλεί να επαναστοχαστούμε πάνω στην ανθρώπινη κατάσταση και τις σχέσεις αυτής με την ηθική και την τεχνολογία. Είναι η τεχνολογία per se που αναπτύσσει τις επιπτώσεις ή ο τρόπος που αυτή εμπλέκεται με τις κοινωνικές, κρατικές και οικονομικές δομές;

Τα ερωτήματα αυτά είχαν γίνει θέμα των φεμινιστικών ερευνών αρκετά πριν γίνουν σημείο αναφοράς των συζητήσεων περί ηθικής της ΤΝ. O όρος «Φεμινιστική Τεχνητή Νοημοσύνη» εμφανίζεται πρώτη φορά το 1995, στο «Embodying Knowledge: A Feminist Critique of Artificial Intelligence» (Adam, 1995). Πλοηγούμενη μεταξύ των βασικών ιδεών της φεμινιστικής επιστημολογίας και των –μέχρι τότε– περιορισμένων δυνατοτήτων της ΤΝ, η Adam ρωτά τί σημαίνει να γνωρίζεις. Δεδομένου ότι η γνώση και η αναπαράστασή της αποτελούν την καρδιά της ΤΝ, στη μελέτη της Adam το φύλο γίνεται αναλυτικό εργαλείο για την εξερεύνηση του πώς τα συστήματα αυτά αναπαριστούν τη γνώση, ποιου είδους γνώση αναπαρίσταται και ποιος την κατέκτησε.

Σύμφωνα με την Adam η ΤΝ μετουσιώνει ψηφιακά την ιδέα του καρτεσιανού δυϊσμού. Ο νους διαχωρίζεται από το σώμα και δεν επικρατεί απλά έναντι αυτού, αλλά το συνθλίβει. Δίνεται έμφαση στις αναπαραστάσεις προτασιακής λογικής, μια σύγχρονη εκδοχή νοησιαρχίας, όπου η γνώση οργανώνεται μέσω αυστηρών κανόνων της μορφής «αν-τότε». Αυτό συνεπάγεται έναν τρόπο κατανόησης της πραγματικότητας που βασίζεται στην έκφραση «ο-S-ξέρει-ότι-p» – με τον S να λειτουργεί ως ένας παντογνώστης παρατηρητής και το p ως ένα αληθές, μονοσήμαντα ερμηνεύσιμο παρατηρούμενο γεγονός. Άλλωστε, η ιδέα της αμερόληπτης και καθολικής αναπαράστασης της πραγματικότητας, ή αλλιώς το «τέχνασμα του Θεού» όπως διατυπώθηκε από τη Haraway, είχε βρεθεί στο στόχαστρο των φεμινιστικών κριτικών πολύ πριν γίνει σχετική με το ζήτημα της δικαιοσύνης των συστημάτων ΤΝ. Σύμφωνα με τη Haraway, κάθε γνώση παράγεται σε –και συγκροτείται από– συγκεκριμένα κοινωνικά, πολιτισμικά και ιστορικά πλαίσια, εντός των οποίων χρησιμοποιείται (Pinto, 2020). Αμφισβητώντας την παραδοσιακή άποψη που καθιστά την έννοια της αντικειμενικότητας ταυτόσημη με τη «θέαση των πάντων από το πουθενά», η Haraway επανατοποθετεί το υποκείμενο που γνωρίζει, στις κοινωνικές συντεταγμένες μέσα στις οποίες γνωρίζει. Αυτή η τοποθέτηση, η συνειδητοποίηση δηλαδή ότι τα ιδιάζοντα κοινωνικά χαρακτηριστικά μίας περιόδου διαμορφώνουν τον τρόπο που αντιλαμβανόμαστε τον κόσμο, δεν αναστέλλει την κατάκτηση της αλήθειας. Αντιθέτως, η αναστοχαστική αναγνώριση της τοπικότητας συμβάλλει σε ισχυρότερες και πιο αξιόπιστες μορφές γνώσης, που συλλαμβάνουν την πολυπλοκότητα και την πολλαπλότητα των κοινωνικών οπτικών.

Υιοθετώντας τη θέση της Haraway για την κοινωνική τοποθέτηση κάθε μορφής γνώσης, η Adam καλεί σε επαναξιολόγηση των αξιωμάτων πάνω στα οποία στηρίζεται η φιλοσοφία σχεδιασμού της ΤΝ. Προτείνει τη μετατόπιση από τις παραδοσιακές απόψεις του Διαφωτισμού περί νοημοσύνης ως ορθολογικότητας προς μία πιο συμπεριληπτική κατανόηση του όρου, στην οποία θα λαμβάνεται υπόψη ο ρόλος της ενσώματης εμπειρίας στην παραγωγή γνώσης. Η Adam «αντιστέκεται» για δύο λόγους. Πρώτον, διότι πολλά από όσα γνωρίζουν οι γυναίκες δεν μπορούν να διατυπωθούν υπό το πρότυπο της προτασιακής λογικής και, δεύτερον, διότι αυτή ακριβώς η αδυναμία μετάφρασης των γυναικείων βιωμάτων συμβάλλει στην απαξίωση της γνώσης των γυναικών, αν όχι ως μη-γνώσης, σίγουρα ως ασήμαντης (Adam, 1996).

Όταν έγραφε η Adam, το αντικείμενο της κριτικής της –τα συστήματα ΤΝ της εποχής– ήταν σε πρωτόλεια μορφή σε σύγκριση με αυτά που χρησιμοποιούμε σήμερα. Οι παρατηρήσεις της, περισσότερο ως ανησυχίες, δεν είχαν περάσει ακόμα από τη σφαίρα του θεωρητικού σε αυτή του εφαρμοσμένου. Τριάντα χρόνια αργότερα, οι βασικές θέσεις της Adam παραμένουν επίκαιρες και το κέντρο βάρους της φεμινιστικής κριτικής εντοπισμένο στο πώς η γνώση της ΤΝ, όπως κάθε άλλη γνώση, διέπεται από υπόρρητες σχέσεις εξουσίας. Η φεμινιστική σκέψη έχει ασκήσει ισχυρή κριτική στους τρόπους με τους οποίους τα συστήματα ΤΝ τυποποιούν, ταξινομούν και ενισχύουν ιστορικές μορφές διακρίσεων. Η προσοχή στρέφεται, πρωτίστως, στην ίδια την διαδικασία ταξινόμησης των δεδομένων, η οποία νοείται από τους φεμινιστικούς κύκλους ως πράξη πολιτική: ποιος επιλέγει, καταγράφει και ερμηνεύει τα δεδομένα που θα χρησιμοποιηθούν; Υπάρχει μία και μοναδική, απόλυτη αλήθεια στα δεδομένα; Είναι οι διαπιστωμένες αλγοριθμικές προκαταλήψεις «απλώς» αποκλίσεις από –κατά τα άλλα– ορθώς ορισμένες τιμές, ή μήπως είναι ενδείξεις ελλιπούς και αφελούς προεπεξεργασίας (Lee et Singh, 2021);

Στόχος της φεμινιστικής κριτικής είναι η συνειδητοποίηση ότι οι περίπλοκες διαδικασίες καθορισμού χαρακτηριστικών, προκαταρκτικής ταξινόμησης των δεδομένων εκπαίδευσης και «ρύθμισης» κατωφλίων και παραμέτρων βασίζονται στην ανθρώπινη κρίση. Συγκεκριμένα, επικρίνουν την «προδιάθεση» των ερευνητών της ΤΝ να σχηματίσουν βιαστικούς ορισμούς και αυστηρές τομές μεταξύ όσων υπάρχουν, στριμώχνοντας την πραγματικότητα σε «ετικέτες». Η κατηγοριοποίηση των δεδομένων, όπως γίνεται σήμερα, στοχεύει στην «επιβολή της τάξης μέσα στην ακαταστασία της ζωής» (West, 2020), καταλήγοντας όμως να «ισοπεδώνει» την ποικιλομορφία της ανθρωπότητας και να κρατά κεκαλυμμένη την κοινωνική ανισότητα.

Οι έμφυλες προκαταλήψεις που ενσωματώνονται στα συστήματα ΤΝ δεν αποτελούν σφάλματα ή βλάβες, αλλά το αποτέλεσμα χρόνιων δομικών ανισοτήτων. Στη νέα ψηφιακή πραγματικότητα, αυτές οι προκαταλήψεις είναι ακόμα δυσκολότερο να ανιχνευθούν, ιδιαίτερα τη στιγμή που ο ίδιος ο σκοπός των συστημάτων υποτίθεται πως είναι να υπερβούν την ανθρώπινη μεροληψία (Wajcman & Young, 2023). Οι ισχυρισμοί του τύπου «το έκανε ο αλγόριθμος» και οι λοιπές συμπαραδηλώσεις περί ηθικής υπαιτιότητας είναι ορισμένοι από τους λόγους για τους οποίους η φεμινιστική κριτική στην ΤΝ είναι αναγκαία. Έμμεσα είτε άμεσα, υπάρχει πάντα ένας άνθρωπος που φέρει την ευθύνη για τις αποφάσεις που λαμβάνονται ή καθοδηγούνται από έναν αλγόριθμο (Greene et al., 2019). Αλλά ποιος;

H Adam παραθέτει: «Δεν με ενδιαφέρει το φύλο των ατόμων που εμπλέκονται, αλλά το φύλο των ιδεών που παράγουν» (Adam, 1996, σελ. 49). Ωστόσο φαίνεται πως αυτά τα δύο δεν είναι ανεξάρτητα: είναι σημαντικό το ποιος «είναι στο δωμάτιο» και ακόμα σημαντικότερο το ποιος απουσιάζει. Σύμφωνα με έρευνα του World Economic Forum το 2023, το 70% των ειδικών στην ΤΝ ήταν άνδρες και μόλις το 30% γυναίκες (WEF, 2023). Και ενώ η συμπερίληψη των γυναικών σε ανάλογες θέσεις εργασίας προβάλλει ως ανάγκη επιτακτική, από μόνη της δεν είναι αρκετή. Παράλληλα, οι στατιστικές μέθοδοι ή η ανάκληση προκατειλημμένων συστημάτων δεν αρκούν για να καταπολεμήσουν την «αλγοριθμική καταπίεση». Αυτό που χρειάζεται είναι να αναγνωριστεί η υποβόσκουσα ιεραρχική λογική που εξαρχής «δημιούργησε» προνομιούχα και μη-προνομιούχα υποκείμενα (West, 2020). Επιστρέφοντας στο παράδειγμα της Amazon, προφανώς και η κατάργηση του ελαττωματικού εργαλείου προσλήψεων δεν ισοδυναμεί με τη λύση του προβλήματος. Εν προκειμένω, το πρόβλημα δεν ήταν το ίδιο το σύστημα, αλλά τα έτη προκατάληψης που διαμόρφωσαν την εταιρική κουλτούρα της Amazon ως ανδρική.

Γιατί λοιπόν χρειαζόμαστε καλύτερη Τεχνητή Νοημοσύνη; Η απόπειρα βελτιστοποίησης αυτών των συστημάτων είναι πολλά παραπάνω από απόπειρα ενίσχυσης της τεχνοεπιστημονικής «αποδοτικότητας». Παραφράζοντας την Fehr, «αυτές οι μηχανές πρέπει να αλλάξουν, όχι επειδή εισάγουν ή προκαλούν τον σεξισμό, αλλά επειδή καθιστούν πιο δύσκολο το να αντισταθούμε στο σεξισμό που βιώνουμε ήδη» (Fehr, 2022).

ΑΝΤΙ ΕΠΙΛΟΓΟΥ: ΕΊΝΑΙ ΑΥΤΉ Η ΤΕΧΝΗΤΗ ΝΟΗΜΟΣΥΝΗ ΑΡΚΕΤΑ ΚΑΛΗ;

Μισό αιώνα μετά την πρώτη εφαρμογή της στην καθημερινή μας ζωή, η ΤΝ έχει αλλάξει ριζικά τον τρόπο με τον οποίο πλοηγούμαστε στην κοινωνική πραγματικότητα. Την ίδια στιγμή που οι εκφάνσεις της ζωής μας μεταφορτώνονται η μία μετά την άλλη στον υπολογιστικό κόσμο, η ρομαντικοποίηση της ψηφιοποίησης φαίνεται να καταρρέει: παρά την ταχύτητα, την αποδοτικότητα, τις δυνατότητες αυτοματοποίησης και την πρόσβαση σε υπέρογκα σύνολα δεδομένων, τα συστήματα ΤΝ, ως κοινωνικά προϊόντα, αντανακλούν –και συχνά οξύνουν– τις ανισότητες που συναντώνται στο εκάστοτε χωροχρονικό πλαίσιο δημιουργίας τους.

Η έµφυλη µεροληψία των συστηµάτων ΤΝ, συνιστώντας πολλά περισσότερα από «τυχαίο» σφάλµα ή τεχνική ατέλεια, αναδύεται ως το ψηφιακό ανάλογο επίµονων κοινωνικών ανισοτήτων και δοµικών ανισορροπιών. Σε ηθικό επίπεδο, ο τρόπος µε τον οποίο οι αλγόριθµοι «βλέπουν», «µιλούν» και «αποφασίζουν» για τις γυναίκες θέτει υπό αµφισβήτηση την ίδια την αξία της τεχνολογίας ως εργαλείου προόδου και ευηµερίας. Σε πρακτικό επίπεδο, οι αθεµελίωτες αλγοριθµικές διακρίσεις οδηγούν σε λιγότερο αποδοτικά και αξιόπιστα συστήµατα, περιορίζοντας τις ευκαιρίες και τις δυνατότητες που προσφέρει η ΤΝ. Δεδοµένου πως, όπως κάθε άλλο τεχνολογικό προϊόν, η ΤΝ δεν είναι αξιακά ουδέτερη, οφείλουµε να αναρωτηθούµε: ποιές αξίες και ποιά συµφέροντα θα θέλαµε να εκπροσωπούνται στην ολοένα κλιμακούμενη ψηφιακή επανάσταση;

ΒΙΒΛΙΟΓΡΑΦΙΑ

ΕΛΛΗΝΟΓΛΩΣΣΗ

Μήτρου, Λ., 2023. Μπορεί ο αλγόριθμος… Αθήνα: Πανεπιστημιακές Εκδόσεις Κρήτης.

Τάσης, Θ., 2019. Ψηφιακός Ανθρωπισμός. Αθήνα: Αρμός.

ΞΕΝΟΓΛΩΣΣΗ

Adam, A., 1995. A Feminist Critique of Artificial Intelligence. European Journal of Women’s Studies, 2(3), 355-377. https://doi.org/10.1177/135050689500200305

Adam, A., 1996. Constructions of gender in the history of artificial intelligence. IEEE Annals of the History of Computing, 18, 47-53. https://doi.org/10.1109/MAHC.1996.511944

Bolukbasi, T., Chang, K., Zou, J., Saligrama, V., & Kalai, A., 2016. Man is to Computer Programmer as Woman is to Homemaker? Debiasing Word Embeddings. arXiv. https://arxiv.org/abs/1607.06520

Dreyfus, H., 1992. What Computers Still Can’t Do: A Critique of Artificial Reason. New York: MIT Press.

Fehr, C. (2022). Feminism, Social Justice, and Artificial Intelligence. Feminist Philosophy Quarterly, 8(3/4). https://doi.org/10.5206/fpq/2022.3/4.15643

Garg, N., Schiebinger, L., Jurafsky, D., & Zou, J., 2018. Word embeddings quantify 100 years of gender and ethnic stereotypes. Proceedings of the National Academy of Sciences of the United States of America, 115(16), E3635–E3644. https://doi.org/10.1073/pnas.1720347115

Greene, D., Hoffmann, A., & Stark, L., 2019. Better, Nicer, Clearer, Fairer: A Critical Assessment of the Movement for Ethical Artificial Intelligence and Machine Learning. Proceedings of Hawaii International Conference on System Sciences.DOI:10.24251/HICSS.2019.258

Eubanks, V., 2018. Automating Inequality: How High-Tech Tools Profile, Police, and Punish the Poor. NY: St. Martin’s Press.

Langenkamp, M., Costa, A., & Cheung, C., 2020. Hiring Fairly in the Age of Algorithms. arXiv. https://arxiv.org/abs/2004.07132

Lee, M., & Singh, J., 2021. The Landscape and Gaps in Open Source Fairness Toolkits. New York: Association for Computing Machinery. https://doi.org/10.1145/3411764.3445261

Nicholas, G., & Bhatia, A., 2023. Lost in Translation: Large Language Models in Non-English Content Analysis. arXiv. https://arxiv.org/abs/2306.07377

Noble, S., 2018. Algorithms of Oppression: How Search Engines Reinforce Racism. New York: NYU Press, 374(6567), 542. https://doi.org/10.1126/science.abm5861

Pinto, M., 2020. Ignorance, Science, and Feminism. In Kristen Intemann & Sharon Crasnow (eds.), The Routledge Handbook of Feminist Philosophy of Science. New York, New York: Routledge.

Prates, M., Avelar, P., & Lamb, L., 2019. Assessing gender bias in machine translation: A case study with Google Translate. Neural Comput & Applic 32, 6363–6381. https://doi.org/10.1007/s00521-019-04144-6

Schwemmer, C., Knight, C., Bello-Pardo, E. D., Oklobdzija, S., Schoonvelde, M., & Lockhart, J. W., 2020. Diagnosing Gender Bias in Image Recognition Systems. Socius: Sociological Research for a Dynamic World, 6. https://doi.org/10.1177/2378023120967171

Steed, R., & Caliskan, A., 2021. Image Representations Learned With Unsupervised Pre-Training Contain Human-like Biases. (FAccT ’21). Association for Computing Machinery, New York, 701–713. https://doi.org/10.1145/3442188.3445932

Wajcman, J., & Young, E., 2023. Feminism Confronts AI: The Gender Relations of Digitalisation. Ιn Jude Browne, Stephen Cave, Eleanor Drage, Kerry McInerney (eds.), Feminist AI: Critical Perspectives on Algorithms, Data, and Intelligent Machines. Oxford: Oxford University Press. https://doi.org/10.1093/oso/9780192889898.003.0004

World Economic Forum, 2023. Global Gender Gap Report 2023. Geneva. https://www3.weforum.org/docs/WEF_GGGR_2023.pdf.

West, S.M. (2020). Redistribution and Rekognition: A Feminist Critique of Algorithmic Fairness. Catalyst, 6(2). https://doi.org/10.28968/cftt.v6i2.33043

Η Μαρκέλλα Χαλλιορή έχει αποφοιτήσει από τη Σχολή Ηλεκτρολόγων Μηχανικών & Μηχανικών Υπολογιστών του Εθνικού Μετσόβιου Πολυτεχνείου. Ολοκλήρωσε το μεταπτυχιακό πρόγραμμα σπουδών «Ιστορία και Φιλοσοφία της Επιστήμης και της Τεχνολογίας» στο Εθνικό Καποδιστριακό Πανεπιστήμιο Αθηνών.